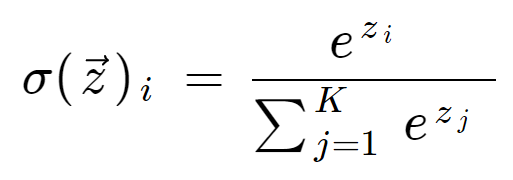

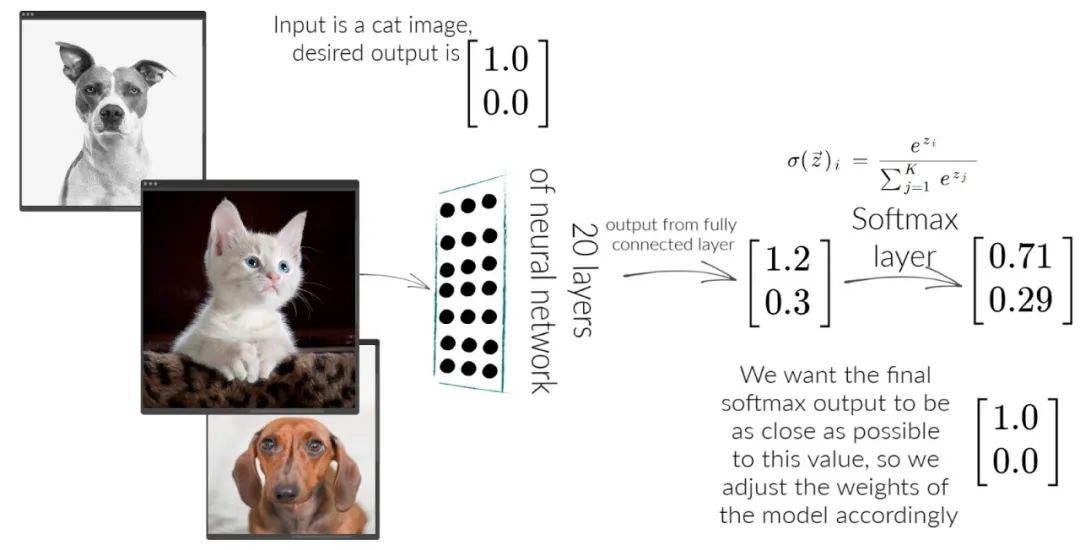

Softmax,这个概念参考[1]解释的非常仔细,这里只做简述,先上公式:

这公式是啥子意思呢?先看一个应用:

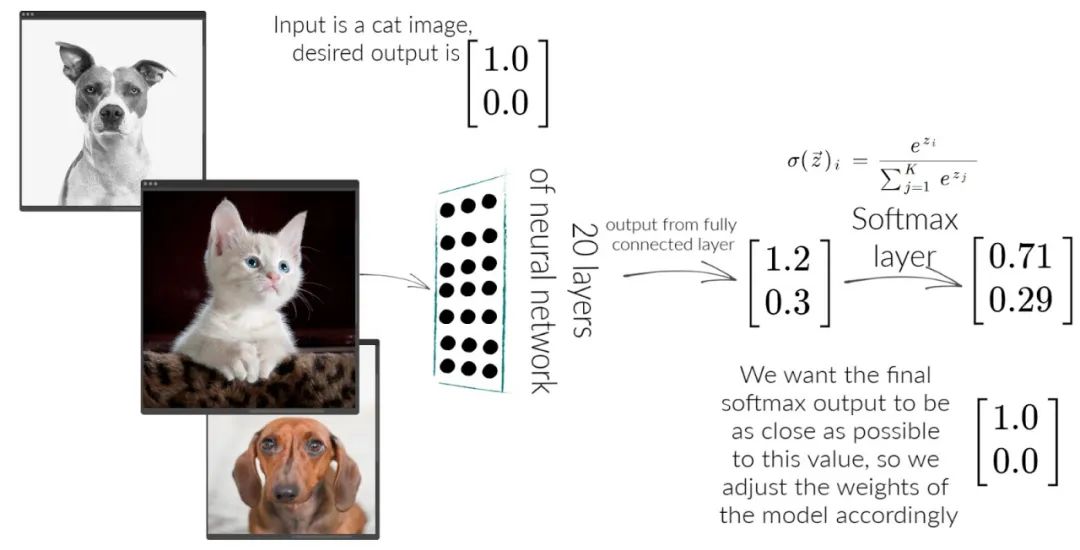

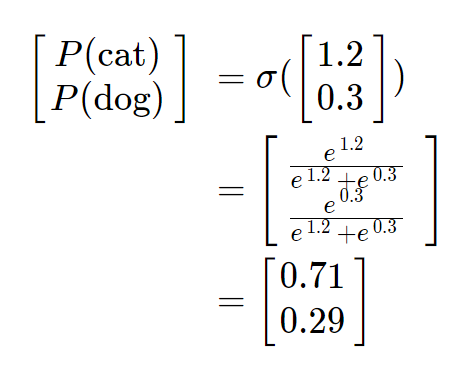

假如我们现在有一个分类任务,如果模型足够理想,输入一张猫图,输出[1, 0],输入一张狗图,输出[0, 1]。通常这种任务,前面会是一个深度卷积神经网络,最后会有一个全连接层,经过这个全连接层会得到图的特征向量(embedding),我自己喜欢管embedding叫特征向量。上图中最后得到的特征向量是[1.2, 0.3],再经过softmax:

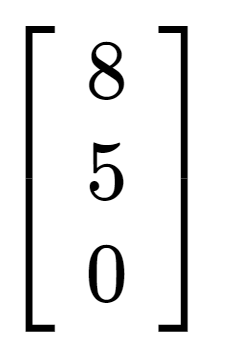

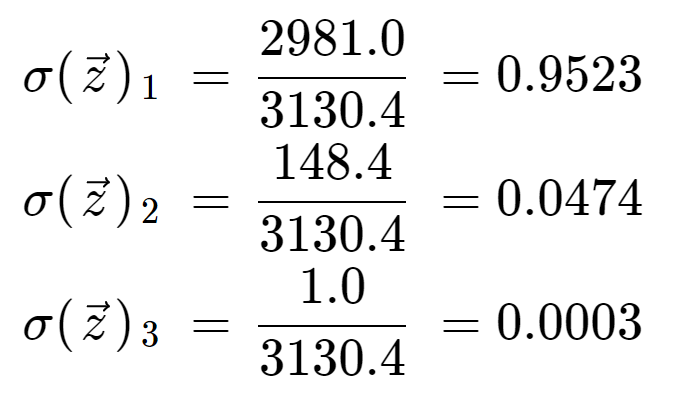

得到了[0.71, 0.29],我们可以这样理解最后这个结果,这张图是猫的概率是0.71,是狗的概率是0.29,它们两加起来是1,不管softmax的输入向量为何,输出向量里的值相加一定是1,得到的结果可以理解为图在各个类上的概率分布,向量的长度即类别(class)的数量。再以一个长度为3的一维向量为例:

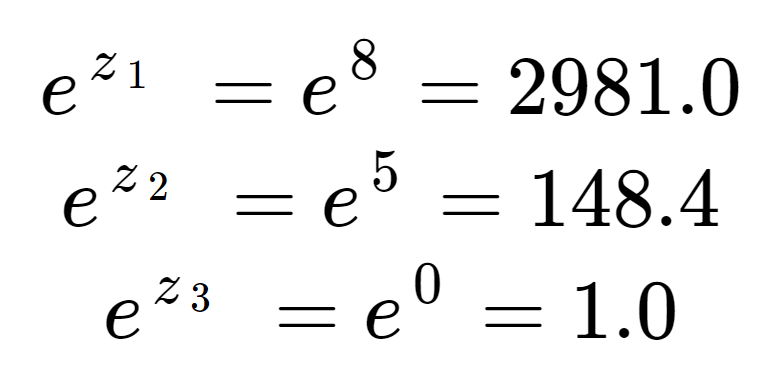

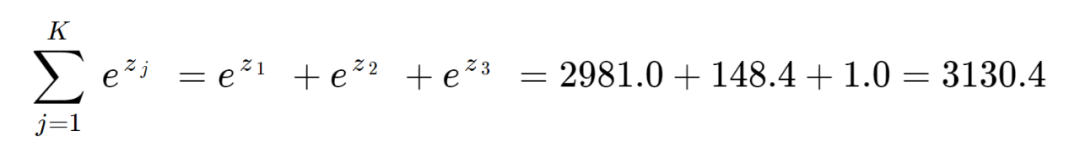

假设你现在要训练一个模型,它需要有能力分辨猫,狗,鸟,你模型训练好以后,输入了一张鸟图,得到了一个这样的特征向量,现在要做softmax,计算步骤如下:

所以按模型判断,该图是鸟图的概率是0.0003,明显这个模型不准诶。

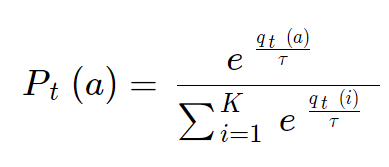

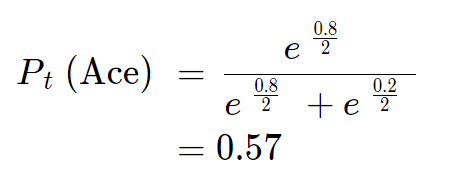

softmax还可用于增强学习(reinforcement learning),先上公式:

在机器视觉领域,softmax的输出,是图像在各个类别上的概率分布,在增强学习领域,softmax的输出可以是各个策略的在某个步骤或时间会被采取的可能性。公式中a是我们可以选的行动,t表示的是步骤或者时间,τ是系统温度,这个值越高,模型越冲动,越会去探索新的可能。qt(a)是从现在已知的情况来看,选择行动a会获得成功的概率,Pt(a)则是模型在t这个步骤或时间上会采取a行动的概率。

想象一下,我们正在训练一种强化学习模型。我们必须配置一个系统温度τ,它是系统随机行动的可能性。该系统目前有两个选项:打Ace或打King。根据过往经验,打Ace成功的概率是80%,打King成功的概率是20%。我们将温度τ配置为2。

那么在这一轮中,模型打Ace的概率是:

这意味着尽管该模型目前有80%的把握确定打Ace是正确的策略,但只有57%的可能性使用该策略。这是因为在强化学习中,我们为探索(测试新策略)和开发(使用已知策略)均分配了价值。如果我们提高温度,则该模型将变得“更具冲动性”:更有可能探索新策略,而不是使用最有可能获胜的策略。

声明:图文,案例均来自参考,本篇仅是翻译和摘要。

参考:

[1] Thomas Wood,Softmax Function Definition, DeepAI

##

的设计/28.png)

Comments