系列首篇:MIT因果迷你课笔记 —— 相关和因果

上篇:MIT因果迷你课笔记 — 因果归纳和机器学习之强化学习

这是这门课最后一部分的内容,因果归纳和机器学习。

总共分四个部分,这是第四部分,讲因果归纳和Domain Adaptation。

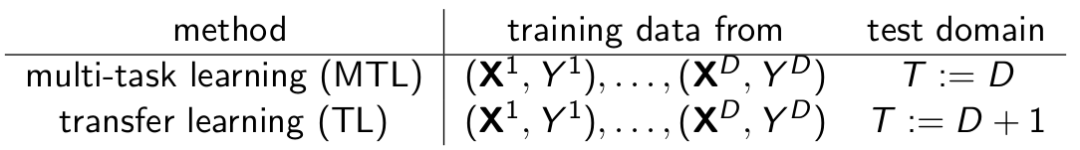

先理解 Multi-task Learning (MTL)和 Transfer Learning 的概念。

(引用自参考[2]) Multi-task Learning (MTL),只专注于单个模型可能会忽略一些相关任务中可能提升目标任务的潜在信息,通过进行一定程度的共享不同任务之间的参数,可能会使原任务泛化更好。广义的讲,只要loss有多个就算MTL。

(引用自参考[3])Transfer Learning的初衷是节省人工标注样本的时间,让模型可以通过已有的标记数据(source domain data)向未标注数据(target domain data)迁移。从而训练出适用于target domain的模型。举个例:

上图是某行人检测任务数据集当中的4张图片,假设前两张正对着摄像机的行人作为训练集,后两张背对着的行人图片作为测试集,结果该模型的测试评分会很差,因为训练时没有考虑到摄像机观察角度引起的问题,类似的在图像识别领域有很多因素会降低识别率(例如光照,背景等)。那能否用一些未标记的图片(类似图3,4这样的图),增强我们的行人检测模型,让它不仅可以识别正对着的行人,还可以识别背对着的行人?这就是迁移学习要干的事。

由上面的概念可知,MTL的训练数据来自不同的域(domain),而应用的场景可能只是训练数据中的其中一个域。TL的训练数据来自不同的域,而应用的场景是训练数据中没有的域。

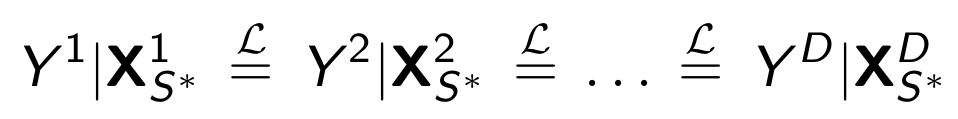

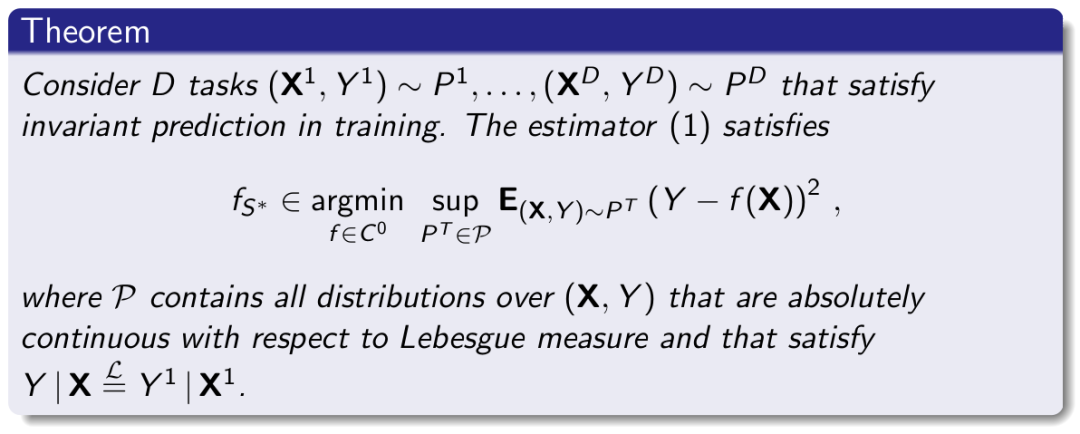

现在有一个假设:

这个假设叫做Coverage Shift Assumption(注:因为视频和课件中均没有出现文字版的名字,不知道这三个单词我打对了没)。这个假设是说对于所有域,以X为条件的Y的分布是一致的,如上式所示。

首先说明,这只是一个假设,不是完美的。另外,从因果的角度来检讨,也有些不那么自然的地方。因为会影响Y的是Y的因,而显然X中不是所有特征都是Y的因。

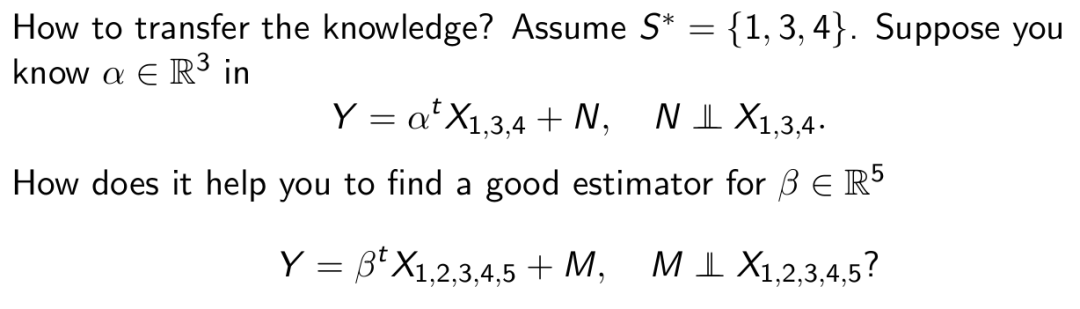

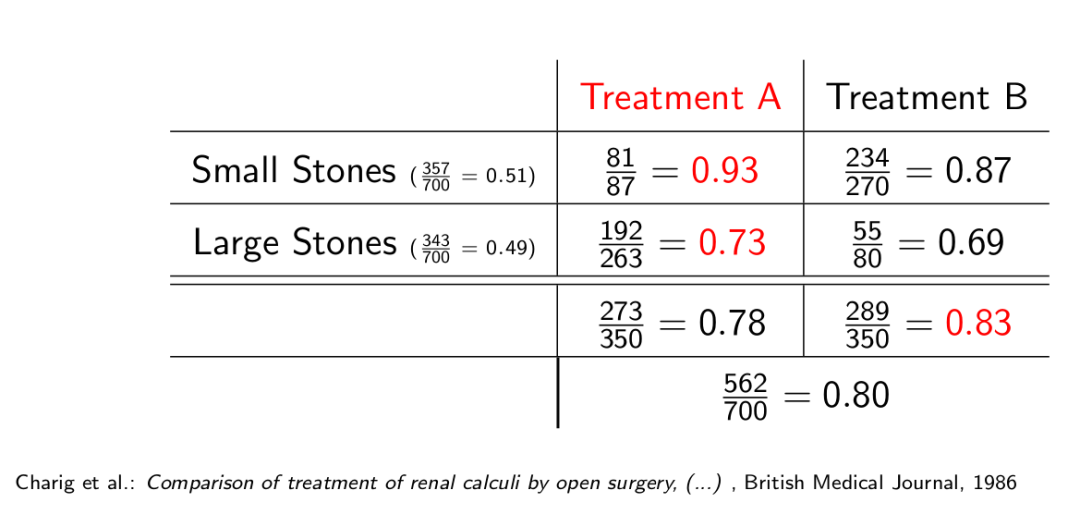

那如何根据上面的假设传递知识:

上面公式中1,2,3,4,5这些可以看成是不同domain的编号,也就是说有些域和Y之间的关系是已知的(比如有打过标签的训练数据,训练过),但有些域和Y之间的关系是不知道的(比如有些域的数据没有打过标签,没有参与训练模型),那如何从已知的Y和一些域的关系去推导Y和另外一些域的关系?

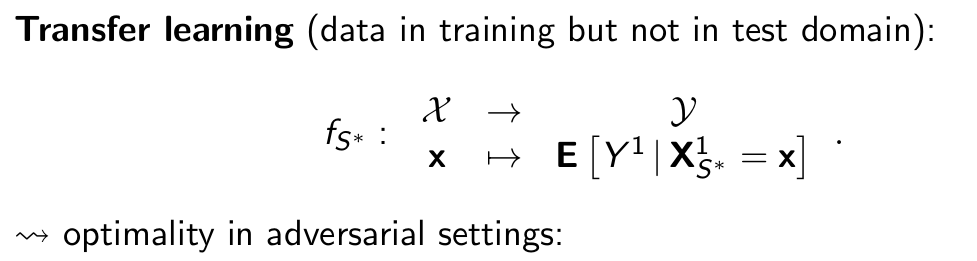

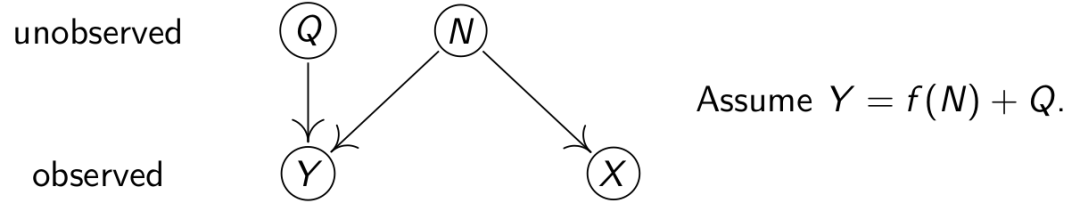

上图是授课老师展示的一个方案,这里就不细说了,因为他没细说,我也没明白。

另外一个原因是Domain Adaptation还在概念的阶段,不是一个成熟的课题,所以这里的主要任务是抛出问题,引发思考,感兴趣的可以深入了解一下。

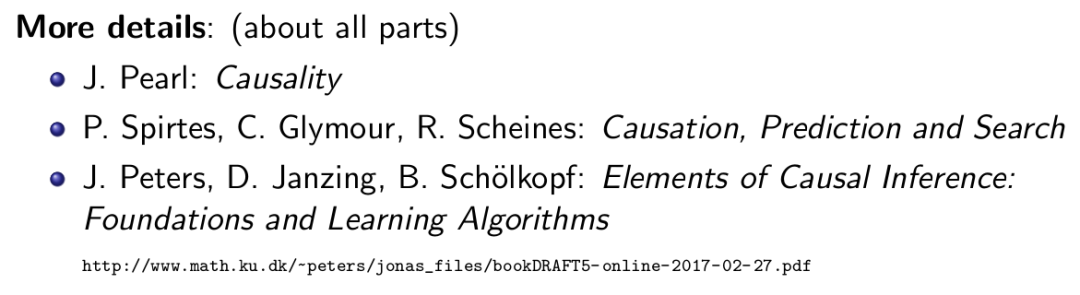

到这里,这门因果课就结束啦,下面是授课老师推荐的一些相关的书,可供参考:

最后再回头说一说进入这个领域的初衷(改自课程老师在该课程最后十分钟说的一段话),我想对这个领域感兴趣的大多数人,都是人工智能领域的学者,现在深度学习大热,所有问题都开始用端到端的方式解决了,也取得了很好的效果。但是我们仔细想一下,知道这其中是有问题的,问题在于真正的智能,比如我们人类,解决问题不都是端到端的,人类擅长总结,概括,类比,推理,归纳因果,甚至进行想象,反事实等,我们下围棋不一定能赢过机器人,但我们下围棋的策略,是根据游戏规则,自身经验,推理而来的,再比如人类归纳因果也不总是对的,但我们的行为背后总有动机在支撑。这是现在的人工智能无法做到的。虽然目前因果归纳并没有在人工智能领域取得什么好的成果,但仍有很多学者和科学家坚信,在人工智能领域加上因果归纳,也许会让我们更接近强人工智能。

完结,撒花,希望所有的时间都没有白费,期待下一段旅程,觉得有用的话,右下角帮忙点个‘在看’哦!恭喜发财,感激不尽。

系列首篇:MIT因果迷你课笔记 —— 相关和因果

上篇:MIT因果迷你课笔记 — 因果归纳和机器学习之强化学习

记:公式上上下下有不匹配的地方,因为截自不同的参考文献,所以写法会有出入,打公式太累了,我放过了自己。

声明:所有图片均来自参考,没有原创图片,公式和定理。

参考:

[1] Jonas Peters, University of Copenhagen, Mini-course on Causality, Laboratory for Information & Decision Systems (LIDS) and Models, Inference & Algorithms of the Broad Institute, MIT, 2017

[2] Anticoder, Multi-task Learning(Review)多任务学习概述,2019

[3] Xf Mao,什么是迁移学习 (Transfer Learning)?这个领域历史发展前景如何?,2017

Comments